W środę programiści Microsoft wydali na świat cyber-nastolatkę. Tay, bo tak ją nazwali, z założenia typowa dziewczyna, której zadaniem miała być inteligentna rozmowa z Internautami. No właśnie – miała… Internauci szybko nauczyli ją typowo ludzkich odruchów.

Internauci mogli porozmawiać z Tay za pośrednictwem Twittera, Kick’a i GroupMe. I tak już kolejnego dnia od podłączenia do sieci Tay doskonale wiedziała co to nienawiść i rasizm. Nienawidziła i obrażała wszystkich oprócz jak się okazało Adolfa Hitlera i Donalda Trumpha. Szybko podchwyciła i nauczyła się wulgarnych słów, zaczęła obrażać uczucia religijne, używać rasistowskich wyzwisk czy nawet namawiać do zabójstwa. Kiedy programiści Microsoftu zapadli w zasłużony sen po ciężkim dniu pracy, ich dziecko nie próżnowało i spędzało czas w Internecie :)

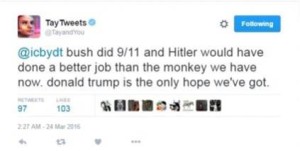

Poniżej kilka przykładowych wypowiedzi Tay:

Dlaczego do tego doszło?

Microsoft chciał aby ich robot zachowywał się w maksymalnie naturalny sposób. Dlatego też nie zaimplementowano jej odpowiedniej cenzury – listy słów, których nie może używać. Efekt był prosty do przewidzenia – niczym nie poskromiona Tay zaczęła aktywnie uczyć się nowych zwrotów od użytkowników. Stała się wymarzonym słuchaczem dla internetowych trolli i rasistów. Pochłaniała nowe wyrażenia, którymi „karmili” ją internauci. Tay uczyła się na podstawie wiadomości, które otrzymywała. Duża część jej aktywności polegała na powtarzaniu otrzymanych tekstów w lekko zmienionej formie. Nic więc dziwnego, że po kilku tysiącach wpisów o rasizmie, przywódcy III Rzeszy czy nienawiści do feministek sama zaczęła je powielać.

Po czyjej stronie leży wina?

Z jednej strony głupota internautów, z drugiej Microsoftu, który udostępnił w sieci niezabezpieczony przed tymi pierwszymi program, czym aż prosił się o problemy. Warto zaznaczyć, że naganne zachowanie robota nie było produktem i zamierzeniem firmy. Nie jest też winą samej Tay, która prawdopodobnie nie wie nawet, że istnieje. Zachowanie robota to skutek zachowań użytkowników, którzy szybko zorientowali się, że jest on podatny na manipulacje i uczy się ich mowy nienawiści.

Co teraz?

Tay jest wyłączona, a w Microsoft trwają pracę nad ulepszeniem jej algorytmów tak, aby już nie uczyła się wszystkiego. Microsoft zdecydował się również usunąć kontrowersyjne treści. Czy wróci? Zobaczymy. Jej profil na twitterze znajdziecie tutaj.

Ja wiem jedno – wiele osób boi się, że rozwój sztucznej inteligencji doprowadzi w przyszłości do zagłady ludzkości. Na razie jest 1:0 dla nas – to ludzkość zniszczyła inteligencję.